En direct avec LeMarson

Vos rendez-vousen directavec LeMarson

pour ne rien rater de l'actualité et des grandes thématiques des tendances informatiques.

Webinaire

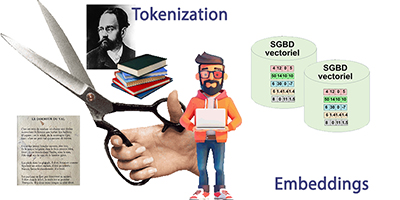

Tokens et "embeddings", c’est quoi ces trucs ?

Les applications de génération IA, quelle que soit la nature des objets à fabriquer, passent nécessairement par 2 phases spécifiques. La "tokenization" revient à découper des objets à analyser en tokens, ceux-ci pouvant être des pixels en niveaux de gris dans une image, des "morceaux" de texte en analyse NLP du langage naturel, des descriptions hétérogènes de ressources, etc. Quant à l’intégration "embeddings", il s’agit de la traduction de la numérisation des tokens en bases de données, le plus souvent vectorielles, susceptibles de stocker des objets à N dimensions.

Il y a beaucoup de concepts nouveaux dans cette approche, ce qui explique sans doute qu’un pourcentage très élevé d’applications de ce type n’aboutissent pas.

Notre webinaire a pour vocation de débroussailler le sujet, à détecter ce qu’il faut savoir, les connaissances à acquérir et le marché dans lequel tout cela s’insère.

Nous ne sommes pas convaincus qu’une application lourde de génération IA portant sur des données privées, mais en utilisant un modèle de génération IA existant, comme les LLM Gemini, ChatGPT ou Claude, soit à réaliser en interne. Les risques sont encore très élevés et peut-être faut-il faire confiance à des prestataires spécialisés -mais il n’y en a pas beaucoup- ou attendre que les expériences se multiplient.

Cela dit, entendons-nous bien, il ne s’agit pas ici de "développer" du code, mais de mettre en place la chaîne de génération, dans laquelle il y aura à traiter les aspects "tokens" et "embeddings".

Si on veut, par exemple, développer une chaîne de recommandation, à la suite de l’achat d’un produit ou effectuer une classification particulière dans notre périmètre de compétences, il faudra traiter les objets, les découper et les stocker en numérique. C’est exactement ce que nous vous proposons d'aborder dans ce webinaire.

Webinaire

La programmation du comportement des réseaux

L'idée d'IBN ("Intent Based Neteworking") revient à considérer les ressources d'un réseau : routeurs, switchs, frontaux, etc, comme des objets dont le comportement peut être programmé via un langage spécialisé.

Une architecture réseau programmée de cette manière intervient à 4 niveaux : la traduction des recommandations en contraintes, le "quoi" en "comment", l'implémentation automatique de la stratégie, la détection en temps réel d'évènements qu'elle fait remonter et la surveillance courante du réseau pour s'assurer qu'il ne dérive pas.

Il existe des langages dédiés à cette surveillance, tel NEMO de l'IETF qui s'applique à la NBI, la "North-Bound Interface", autrement dit les aux liens entre les outils d'administration de haut niveau et les équipements, laissant l'interfaçage avec les SBI ("South-Bound Interface") aux contrôleurs SDN.

Il ne faut pas s'y tromper. Il s'agit là d'une voie très moderne que les architectes empruntent désormais, parfaitement en phase avec le découpage entre ressources "on premise" et Cloud. Les responsables réseaux auraient tort de ne pas s'y intéresser...

Webinaire

Le "prompt", une spécialité à part entière

Il est encore fréquent que le "prompt" ou instruction générative, comme le veut l’Académie Française, gardienne des bonnes règles, soit considéré comme une simple expression libre, un texte en langage naturel émis à destination d’un LLM, un grand modèle de langage dont l’objectif est de générer un résultat, du texte, des programmes, des informations techniques, des images, une vidéo, etc. C’est vrai, sauf qu’il faut respecter quelques idées de base…

On est ici en plein cœur de l’Intelligence Artificielle, car le "prompt" est bien autre chose. C’est une nouvelle spécialité, aussi importante que la programmation, qui permet de "piloter" une LLM, dans de bonnes conditions de réussite, fondée sur des bonnes pratiques et des modèles.

Ici le moyen d’expression est le langage naturel, l’anglais et le français étant évidemment mieux placés que le mandarin ou le créole haïtien. Mais ce n’est pas une science exacte, car il n’existe aucun moyen d’obliger une LLM à fournir quelque chose de précis. Il peut y avoir de nombreuses formulations différentes pour un même besoin, les LLM eux-mêmes (GPT, Claude, Gemini, DeepSeek…) pouvant réagir différemment à une invite identique.

Nous évoquerons dans ce webinaire les compétences qui nous paraissent utiles et qui dépendent de l’objet souhaité, le texte n’ayant pas les mêmes contraintes qu’une image ou une vidéo.

Pour une génération de texte, par exemple, des compétences en termes de linguistique seront très utiles, de même que la connaissance du contexte technique, social, historique… dans lequel les LLM interrogés vont devoir s’exprimer. Générer un code de programmation n’aura aucun intérêt, si nous n’avons pas une connaissance suffisante du langage de programmation concerné.

Bienvenue donc dans ce webinaire et nul doute qu’après, vous ne considèrerez plus le "prompt" comme un simple bout de texte sans importance.

Vos précédents rendez-vous

- Décembre 2025

- Novembre 2025

- Octobre 2025

- Septembre 2025

- Avril 2025

- Mars 2025

- Février 2025

- Janvier 2025

- Novembre 2024

- Octobre 2024

- Septembre 2024

- Juin 2024

- Mai 2024

- Avril 2024

- Mars 2024

- Février 2024

- Janvier 2024

- Décembre 2023

- Septembre 2023

- Juin 2023

- Avril 2023

- Mars 2023

- Février 2023

- Janvier 2023

- Décembre 2022

- Novembre 2022

- Octobre 2022

- Septembre 2022

- Août 2022

- Juin 2022

- Mai 2022

- Avril 2022

- Mars 2022

- Février 2022

- Janvier 2022

- Décembre 2021

- Novembre 2021

- Octobre 2021

- Septembre 2021

- Juin 2021

- Avril 2021

- Février 2021

- Janvier 2021

- Décembre 2020

- Novembre 2020

- Octobre 2020

- Septembre 2020

- Juin 2020

- Mai 2020

- Retour

Abonnez-vous

- Suivez LeMarson en direct

- Accédez à des centaines de dossiers et d'articles

- Visionnez des dizaines d'heures de formations vidéos

- Téléchargez le Livre des tendances de l'année

Annuel